Electrodos y una IA para preguntar "¿me quieres?": consiguen que una persona con parálisis convierta sus pensamientos en voz

Una mujer con una lesión neurológica que le impide hablar ha podido escuchar, en apenas milisegundos, una recreación de su propia voz creada por IA

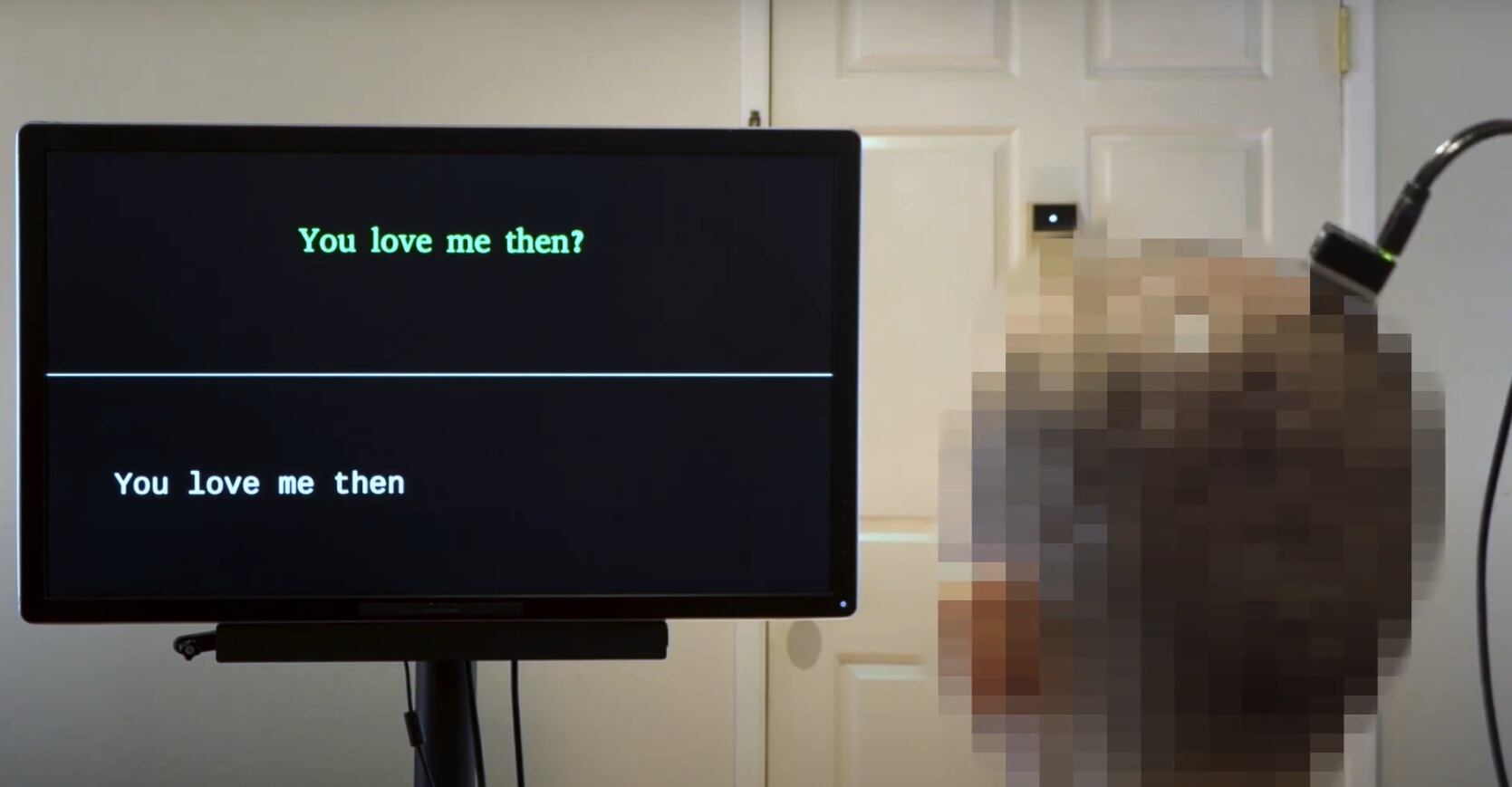

Demostración de síntesis de voz natural y en tiempo real con decodificación de texto a partir de la actividad cerebral / Crédito: Chang et al.

El silencio es total en la habitación. La paciente está de espaldas. En su cabeza tiene una especie de aparato negro y pequeño con dos cables. Delante hay una pantalla negra en la que vamos leyendo distintas frases. Frases triviales y comunes. Nos fijamos en una de ellas en la que alguien pregunta "Entonces... ¿me quieres?".

Hay una pequeña pausa. Muy breve. La mujer -se llama Ann, tiene 47 años y una parálisis severa- está leyendo la pantalla. Lo siguiente que pasa es realmente alucinante: la frase se repite en la parte de abajo y luego una voz, todavía no muy conseguida pero perfectamente audible, la dice en voz alta: "¿Entonces me quieres?".

En inglés, "You love me then?".

Son apenas cuatro palabras que revolucionan la neurociencia y dan una esperanza a las personas con parálisis o enfermedades que les impiden el habla. Las ha generado una Inteligencia artificial a partir de los impulsos eléctricos del cerebro de la mujer. .

Los aparatos BCI

Un dispositivo BCI (Brain-Computer Interface, por sus siglas en inglés) es tecnología que permite la comunicación directa entre el cerebro y un dispositivo externo. Estos aparatos registran la actividad cerebral, la procesan y la interpretan para traducirla en acciones que puede llevar a cabo un dispositivo.

El concepto nos lleva al famoso científico Stephen Hawking. Su sistema BCI utilizaba infrarrojos colocados en sus gafas con los que detectaba los movimientos de su mejilla. Con estos movimientos, Hawking podía seleccionar caracteres en una pantalla y navegar por diferentes menús. Es verdad que el sistema tenía un algoritmo de predicción de texto, similar al de los móviles, que ayudaba a adivinar las palabras que intentaba decir. Lo que recordamos de él es "escribía" las palabras, su texto se convertía en voz mediante un sintetizador. Lo diseñó la empresa Intel, y permitió a Hawking, durante años, comunicarse de manera más o menos efectiva a pesar de sus limitaciones.

Sin embargo, lo que ha presentado un equipo de investigadores de la Universidad de California en Berkeley y San Francisco, liderados por los doctores Chang y Anumanchipalli va mucho más allá: Es una interfaz cerebro-ordenador que puede recrear, en una pantalla y con sonido humano, las frases completas que está pensando una paciente con parálisis, una mujer llamada Ann, de 47 años.

Ya existen algunos sistemas BCI y recientemente hemos visto a uno que permite a un hombre con ELA “hablar” de nuevo. También está en esta carrera Elon Musk con su Neuralink -del que apenas nada- y otra empresa, Meta, anunció recientemente que tiene "una IA que interpreta las señales eléctricas del cerebro como si fueran teclas pulsadas en un teclado". Es decir, ya hay algunos avances en este sentido. Pero ninguno es tan rápido, según sus autores, como el que acaban de presentar a través de varios vídeos en la revista Nature.

¿Cómo funciona?

El equipo de Chang y Anumanchipalli ha publicado en Nature un artículo y varios videos en el que muestran un sistema combinado de electrodos e Inteligencia artificial. Los electrodos se colocan por fuera de la cabeza del paciente. Es decir, son muy poco invasivos. Toda la información que captan, la decodifica un segundo escalón, la IA. Un tercer paso, que se produce muy rápido, sintetiza toda la información en texto -frases que aparecen en una pantalla- y en voz. Y todo esto ocurre "en tiempo real".

En el primero vídeo demostrativo titulado "síntesis de voz naturalista en línea con decodificación de texto sincronizada a partir de la actividad cerebral" vemos a la paciente. La describen como "una persona severamente paralizada que no puede hablar". Tiene el electrodo colocado en la parte trasera de la cabeza.

La mujer lee distintas frases y, en apenas 80 milisegundos, lo que piensa para tratar de repetirlas con su voz-aunque no puede- "es decodificado y sintetizado directamente desde su actividad cerebral".

Lo siguiente que vemos son unas letras en la parte de abajo de la pantalla. La frase de arriba aparece repetida abajo. luego escuchamos una voz que repite las frases con bastante claridad.

En el segundo vídeo, la decodificación y síntesis de los pensamientos de la paciente es mucho más rápida. Y la voz parece mejorada.

El salto adelante respecto a otras neuro-prótesis del habla es gigante.

Estos sistemas de decodificación de señales suelen tener siempre el mismo problema: el desfase de tiempo entre el momento en que se intenta hablar y el momento en que se produce el sonido. El salto adelante de este trabajo es que usando inteligencia artificial, los investigadores han conseguido "un método de transmisión que sintetiza las señales cerebrales en voz audible casi en tiempo real". Lo describen como "un paso crítico para permitir comunicarse a las personas que han perdido la capacidad de hablar".

¿Cómo funciona?

El neurocirujano Edward Chang, coinvestigador del estudio dirige el ensayo clínico en la UCSF que ha desarrollado la neuro-prótesis que vemos en los vídeos. Son "electrodos de alta densidad" que registran la actividad neuronal directamente desde la superficie del cerebro. Funciona "tomando muestras de datos neuronales de la corteza motora", es decir, la parte del cerebro que controla la producción del habla. Son, básicamente, señales eléctricas que luego hay que decodificar.

¿Y como transformar esos impulsos eléctricos en voz? Ahí entra la inteligencia artificial. "Es alucinante la cantidad de avances que vamos a poder hacer con ella en los próximos años", dice Chang, entusiasmado. La posibilidad que tiene de estudiar y entender millones y millones de datos es, otra vez, un salto adelante impresionante

Sabiendo que hay una IA al otro lado para recibir la información, el electrodo que vemos en los vídeos "intercepta" las señales eléctricas del cerebro del paciente justo después de decidir qué va a decir, luego cuando piensa qué palabras va a usar y, por ultimo, cuando le envía esas señales a los músculos del tracto vocal, aunque no funcionen.

Para acelerar todavía más el proceso, los autores han usado usado "un algoritmo similar a la decodificación rápida de voz que tienen Siri o Alexa en nuestros móviles", ha explicado Gopala Anumanchipalli, coinvestigador principal del estudio. Es una IA y un modelo de voz pre-entrenado que genera audios y, además, simular la voz de la paciente antes de que perdiera el habla.

Para entrenar todo este sistema, los investigadores primero hicieron que la paciente -como vemos en los vídeos-mirara un mensaje en la pantalla y luego intentara decir lo que estaba leyendo en voz alta, aunque no pudiera. "Esto nos dio un mapeo de su actividad neuronal", explican. Lo demás lo hizo el algoritmo: ligar esos impulsos genéticos, primero a palabras, después, a frases completas.

Casi en tiempo real

En su estudio anterior de un dispositivo BCI, los investigadores consiguieron decodificar los pensamientos de la paciente pero tenían "una latencia larga para la decodificación": 8 segundos de retraso para una sola oración. Con el nuevo enfoque de transmisión, se puede generar una salida audible casi en tiempo real, mientras el sujeto intenta hablar. Además, el dispositivo "puede decodificar continuamente el habla". Es decir, la paciente pudo seguir hablando sin interrupciones mientras sus pensamientos eran decodificados.

Hasta ahora, "el habla inteligible no podía transmitirse desde el cerebro en tiempo real", explican los autores.

El futuro

Este trabajo acerca a los investigadores al habla natural con dispositivos cerebrales tipo BCI. Los autores han contado que son "muy optimistas". Explican que hay que seguir desarrollando el algoritmo para ver cómo pueden generar voz "mejor y más rápido". Ahora están centrados en "crear expresividad en la voz de salida para reflejar los cambios en el tono o el volumen cuando el paciente está emocionado".

Javier Ruiz Martínez

Redactor de temas de sociedad, ciencia e innovación en la SER. Trabajo en el mejor trabajo del mundo:...