Diseñan un sistema portátil que guía a personas ciegas a través de señales en el oído y el tacto

Utiliza unas gafas que inspeccionar el entorno y, potenciadas por una inteligencia artificial, enviar señales al usuario a medida que se acerca a un obstáculo

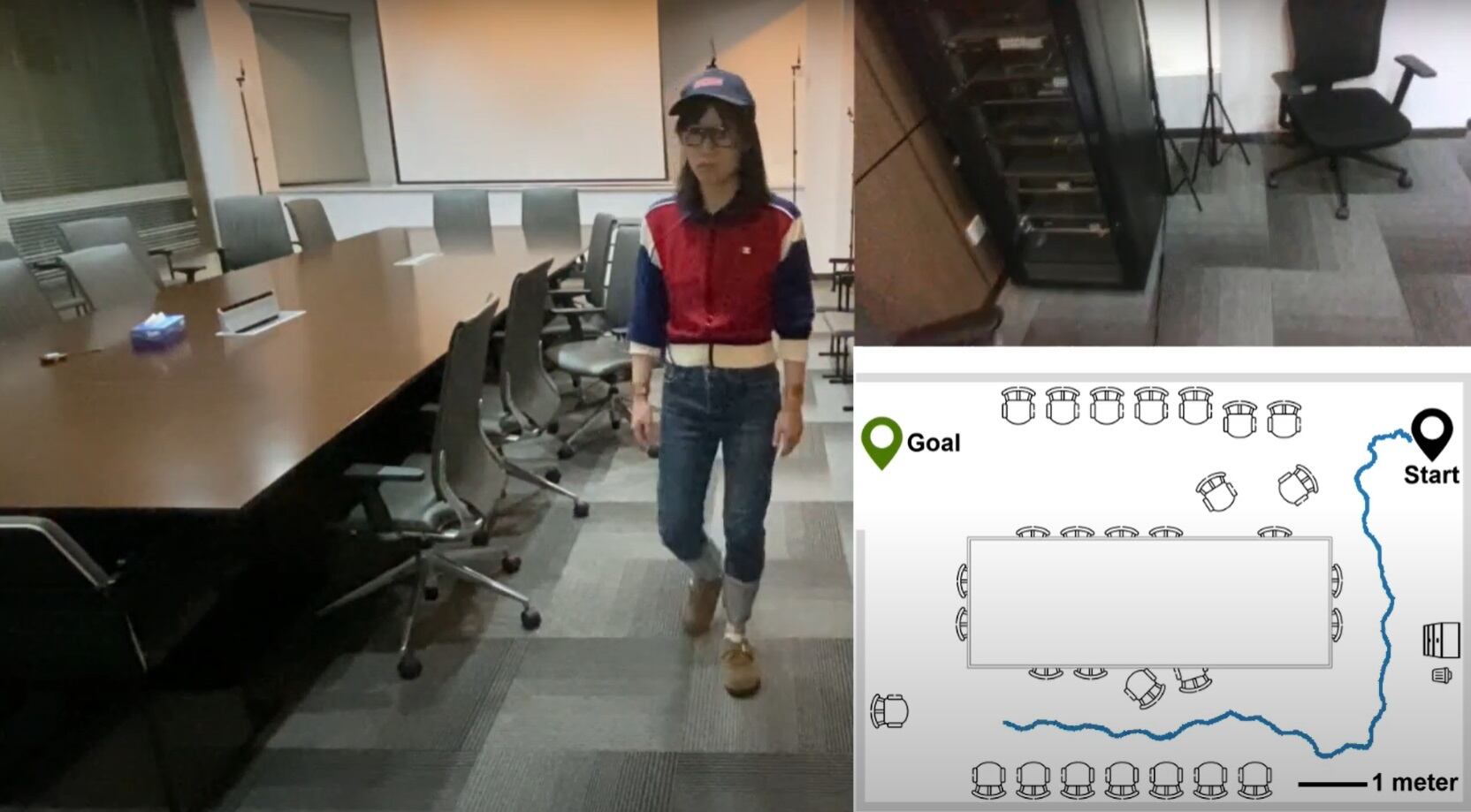

Una de las pruebas del sistema en la una persona rodea una mesa de reuniones sin chocar con las sillas.

Madrid

A diferencia de otros tratamientos médicos o prótesis, este sistema no busca restaurar la visión para personas con distintos grados de ceguera, sino "transformar la información visual que reciben en señales que el cuerpo pueda interpretar a través del oído y el tacto". En las pruebas que acompaña la publicación en Nature, el equipo de Leilei Gu, de la Universidad Jiao Tong de Shanghái, vemos como los usuarios de esta tecnología -primero pequeños robots, luego humanos- van recibiendo en tiempo real datos sobre su entorno, por ejemplo, para tener claro donde hay obstáculos que tienen que sortear.

En el primer vídeo vemos un robot evitar un pequeño cubo en su camino.

En el siguiente, ya vemos a una chica, realizar un recorrido complejo en un laberinto con objetos en su interior y como la tecnología le va avisando.

En otro vídeo, la persona ya está en una sala real en la que rodea una mesa con sillas.

La inteligencia artificial va "viendo" lo que las gafas ven y traduciéndolo a señales.

Y en el último vídeo, progresión continúa y la persona que hace la prueba está en la calle evitando el paso de personas y el choque con objetos cotidianos.

En definitiva, se trata de un sistema portátil que convierte información visual del entorno en otras señales sensoriales para ayudar a las personas con problemas de visión con sus tareas diarias y determinando una ruta libre de obstáculos.

Está formado por:

- Un módulo de visión artificial. Creado a partir de una cámara RGB-D integrada en unas gafas impresas en 3D, se gestiona a través de un simple microcontrolador Raspberry Pi. Captura imágenes en color y con profundidad para detectar objetos, reconocer escenas y calcular rutas sin obstáculos. Incluye infrarrojos para cuando hay poca luz y un sistema de compensación de imágenes borrosas

- Un sistema de retroalimentación auditiva. Son unos auriculares de conducción ósea para guiar al usuario con sonidos espaciales que indican dirección. Utiliza lo que llaman “spatialized cues”, o pistas espaciales, en vez de instrucciones verbales para mejorar la rapidez de reacción.

- Unas pieles artificiales sensorial-motoras. Son pequeños artilugios de plástico que se pegan a la piel de la muñeca y los dedos y que incluyen sensores de distancia. Dan señales por vibración ante obstáculos laterales (en el llamado "modo navegación") y ayudan en tareas de alcance y agarre de objetos (en el que se llama "modo post-navegación"). Permiten una respuesta muy rápida: solo 18 milisegundos.

Javier Ruiz Martínez

Redactor de temas de sociedad, ciencia e innovación en la SER. Trabajo en el mejor trabajo del mundo:...